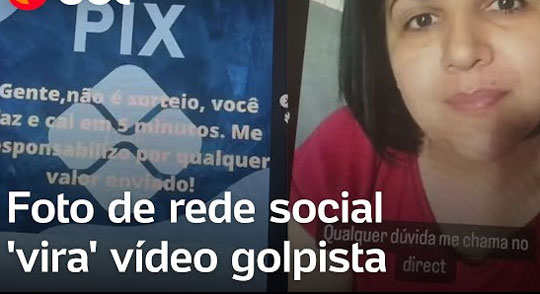

Com inteligência artificial, criminosos usam foto de empresária e criam vídeo com golpe do Pix

Do Uol

A Polícia Civil do Distrito Federal investiga um caso de golpe envolvendo inteligência artificial. Os criminosos usaram a foto do perfil de uma rede social de uma mulher de 40 anos em um vídeo para promover uma pirâmide virtual de Pix. Três contatos dela acabaram fazendo transferência de dinheiro.

Nas imagens criadas por inteligência artificial, a empresária Gizele Mendes mexe a boca e até fala. O vídeo sugere que os seguidores participem de uma pirâmide virtual de Pix. A imagem dela aparece confirmando que ganhou dinheiro com a plataforma.

Os amigos acreditaram que ela havia realmente gravado o conteúdo e depositaram valores que variam entre R$ 300 e R$ 1 mil.

Gizele, moradora de Samambaia, conta que usa a rede social para divulgar principalmente os cardápios do seu restaurante. Até que em um determinado dia, ela tentou fazer o login pelo aplicativo, mas não conseguiu.

“Não ligo muito para redes sociais. Uso minha página realmente mais para negócios. Então, como de costume, coloquei minha senha no aplicativo e foi aí que recebi a mensagem que a senha estava errada. Pensei que era algum erro do sistema e fui trabalhar normalmente. Mais tarde, recebi a ligação de uma amiga informando sobre o vídeo”, conta Gizele Mendes.

A amiga queria confirmar se a postagem realmente era verdadeira, pois Gizele nunca havia publicado um conteúdo parecido. A mensagem dizia que, caso a pessoa depositasse R$ 300, receberia R$ 1.500. Já quem optasse por desembolsar R$ 500, lucraria R$2,5 mil — assim por diante.

“Fiquei desesperada. Era meu rosto, era minha voz, era um vídeo meu. Mas eu nunca havia gravado nada parecido. A situação ficou ainda pior quando recebi ligações de conhecidos dizendo que haviam depositado. Quando disse que era golpe, eles ficaram arrasados”, afirma Gizele.

A empresária, então, procurou um hacker para recuperar a conta e registrou boletim de ocorrência. A polícia investiga os crimes de falsidade ideológica e estelionato. Até a noite de terça-feira (24), nenhum dos envolvidos havia sido identificado e as vítimas não recuperaram o dinheiro.

“Observamos um crescimento volumoso de golpes envolvendo a inteligência artificial, por isso precisamos nos preparar. Os agentes vêm fazendo cursos para se atualizarem e combaterem a deep fake”, disse Tell Marzal, delegado da Delegacia Especial de Repressão aos Crimes Cibernéticos.

‘Desconfiança constante’

O especialista em inteligência artificial e engenheiro de software Paul Hodel diz que evitar as redes sociais não garante imunidade contra golpes. De acordo com ele, a clonagem de voz “pode ser realizada com apenas três segundos de amostragem de áudio”. “Uma ligação ‘por engano’ já seria suficiente para coletar essa amostra. Além disso, uma única fotografia pode ser usada para gerar deep fakes de vídeos muito realista”, explica.

“É crucial manter a desconfiança constante. Antes de tomar qualquer medida, como transferir dinheiro, é aconselhável confirmar a autenticidade de um vídeo ou áudio diretamente com a pessoa em questão. Estabelecer senhas de verificação entre membros da família pode ser uma medida prática para situações de emergência”, sugere o especialista.